Dr. Aleš Završnik, raziskovalec na Inštitutu za kriminologijo pri Pravni fakulteti v Ljubljani

Aleš Završnik je avtor številnih del o rabi velikega podatkovja, algoritmov in umetne inteligence v kazenskem pravu. Do teh novih tehnologij je, drugače od precejšnega dela strokovne javnosti, kritičen. Opozarja, da algoritmi v kazenskem pravu niso nujno nekaj slabega, žal pa večinoma pomenijo pozitiven prispevek zgolj v kazenskih sistemih, ki so že tako slabi, da jim ni več druge pomoči. Enako, če ne še bolj, pa je po njegovem mnenju sporna raba oziroma zloraba teh tehnologij v politiki, saj omogoča »kupovanje« volitev.

Završnik je bil leta 2017 član skupine pri Evropskem raziskovalnem svetu (ERC) za etično presojo novih raziskovalnih projektov.

Računalniški programi in umetna inteligenca so tudi v pravniškem odločanju postali stvarnost. Kje vse se uporabljajo?

Zakup člankov

Celoten članek je na voljo le naročnikom. Če želite zakupiti članek, je cena 4,5 EUR. S tem nakupom si zagotovite tudi enotedenski dostop do vseh ostalih zaklenjenih vsebin. Kako do tedenskega zakupa?

»Zakaj ne bi raje vlagali v ljudi, namesto da vlagamo v stroje?«

Aleš Završnik je avtor številnih del o rabi velikega podatkovja, algoritmov in umetne inteligence v kazenskem pravu. Do teh novih tehnologij je, drugače od precejšnega dela strokovne javnosti, kritičen. Opozarja, da algoritmi v kazenskem pravu niso nujno nekaj slabega, žal pa večinoma pomenijo pozitiven prispevek zgolj v kazenskih sistemih, ki so že tako slabi, da jim ni več druge pomoči. Enako, če ne še bolj, pa je po njegovem mnenju sporna raba oziroma zloraba teh tehnologij v politiki, saj omogoča »kupovanje« volitev.

Završnik je bil leta 2017 član skupine pri Evropskem raziskovalnem svetu (ERC) za etično presojo novih raziskovalnih projektov.

Računalniški programi in umetna inteligenca so tudi v pravniškem odločanju postali stvarnost. Kje vse se uporabljajo?

V kazenskopravnem sistemu imamo sisteme treh vrst. Tiste, ki so v rabi na začetku kazenskega postopka, recimo pri odločanju o priporu, ob koncu kazenskega postopka pa sta tu še odločanje pri izbiri kazenske sankcije in pri pogojnem odpustu. Osredotočam se na kazenskopravni sistem in tu opazujem različne sisteme. V ZDA je raba avtomatiziranih sistemov odločanja tudi način, kako ljudem zagotoviti pravno varstvo. Na primer, da se jim ponudi neki »pametni« spletni obrazec, v katerega lahko vpišejo svojo pravno težavo. Personalizirane storitve so pač drage in si jih ljudje večinoma ne morejo privoščiti, lahko si jih privoščijo samo bogati. V tem primeru ni tako težko ugotoviti, ali so avtomatizirani sistemi, ki temeljijo na velikem podatkovju (big data) in algoritmih, v pravu dobri ali slabi, v tem primeru so gotovo dobri, saj revnejši sloj pride do vsaj nekaj pravnega varstva. Je pa dokaj jasno, da je umetna inteligenca tu uporabljena za reveže, bogati imajo še vedno dostop do obojega – personaliziranih storitev v obliki odvetnikov, ti pa tudi sami uporabljajo avtomatizirane sisteme.

Vsi ti programi odločajo na podlagi statistike in verjetnosti in najbrž nimajo kaj dosti opraviti z okoliščinami v posameznem primeru oziroma s konkretnim človekom, o katerega usodi odločajo?

Zagotovo. Ti sistemi odločajo na podlagi preteklih podatkov, ki jih primerjajo s presojanim primerom. Skratka, če je tvoj primer podoben številnim preteklim primerom, se bo obravnaval tako, kot so se prejšnji primeri. Glavna slabost tega je, da v pravnem smislu tu ni pravne evolucije. To je tudi kritika, ves čas naslovljena na ustvarjalce teh sistemov odločanja v kazenskem pravu, saj zavira pravno evolucijo. Imamo pretekle primere in po izbranih parametrih bo tudi v vseh bodočih primerih odločeno enako. V razvoju prava in človekovih pravic pa so najpomembnejši ravno primeri, v katerih je bilo odločeno drugače kot v preteklih primerih in so pomenili neki kvalitativni ali vrednostni preskok v pravnem razvoju.

Recimo?

Najbolj šolski primer je vsekakor kazenski postopek Miranda proti Arizoni, iz katerega so izšle t. i. Mirandove pravice, ki ljudem v kazenskih postopkih omogočajo »enakost orožja« in se danes zdijo samoumevne. A ta odločitev je bila tedaj »škandalozna«, vzpostavila je novo prakso ravnanja državnega represivnega aparata v razmerju do osumljenca. Česa takega algoritem nikoli ne bo zmogel.

Ne?

Seveda ne. A sestavljavci algoritmov so v bistvu prefrigani. In sicer v smislu, da točno vedo in odkrito govorijo, da ne gre za to, da bi lahko v posameznem primeru odločali povsem individualizirano, pač pa da je to, kar ponujajo trenutno, to, kar zmorejo, vendar je to šele začetek – družba oziroma odločevalci v politiki pa naj se odločijo, ali želijo njihova priporočila pri odločanju sprejemati. Noben pameten podatkovni znanstvenik ne bo rekel, da je to najboljši način za odločanje v pravu, ampak bo rekel, da je najboljši način, ki ga lahko ustvarijo – in če lahko drugi »trdneje« razmislijo o gori podatkov, naj izvolijo to storiti. Pravniki naj se še kar naprej praskajo po glavi in iščejo boljše načine. To je zadnjič dejal podatkovni znanstvenik, profesor z Dukove univerze. Gre za neki cinizem, ki me moti. Pravijo – o primeru bo odločeno na podlagi preteklih primerov, v desetih bistvenih parametrih je podoben preteklim primerom, če pa vi, sodnik, mislite, da lahko v glavi držite več kot deset ali več sto parametrov in milijon primerov, kar lahko stori računalnik, pa to dokažite.

Lahko govorimo, da demokracije ni več, pač pa imamo »algokracijo«, torej nimamo več vladavine prava, ampak vladavino algoritmov.

A človek zmore nekaj, česar algoritem ne zmore, odločiti o primeru, ki je zaradi enega bistvenega parametra drugačen od milijonov primerov pred njim.

Da. Tudi če algoritem računa na podlagi sto parametrov in milijon primerov, je v konkretnem primeru lahko odločil krivično, saj obstaja v tem novem primeru stoprvi parameter, po katerem se primer pomembno razlikuje od drugih. Vzemimo recimo žensko, ki zelo pogosto krade, in algoritem izračuna 95-odstotno verjetnost, da bo ponovila kaznivo dejanje, zato bi ji odredil pripor. Sodnik sicer prav tako meni, da je velika verjetnost, da bo kaznivo dejanje ponovila, a ve, da ima doma tri otroke, in če ne bo priprta, bo lahko še naprej skrbela zanje, zato je v tem primeru manjša družbena škoda, da jo pusti na prostosti, tudi z vidika koristi otrok. Potem podatkovni znanstveniki rečejo, prav, bomo vključili še ta primer »dobre matere« in bo potem računalnik v prihodnjem podobnem primeru odločil drugače. A za stoprvim primerom oziroma specifičnim parametrom v podobnih primerih pride stodrugi, stotretji … Z računalniškim odločanjem v kazenskem pravu je nekako tako kot z »nezrelo« demokracijo – vas vzhodne Evropejce pestijo težave korupcije in klientelizma, ker niste »zreli«, na Zahodu je povsem drugače. Sistem je nastavljen, samo potrpeti je treba in bo prej ali slej postal odličen, do takrat pa nas predvsem poslušajte.

Kar pa se ne bo nikoli zgodilo?

Gre za to, da se je že zgodilo. Pri algoritmičnem samoučenju gre za argument ad infinitum: avtomatizirano odločanje bo odlično v točki v prihodnosti, ki se ji asimptotično približujemo. Če pogledamo ZDA, je seveda po svoje preveč preprosto reči, da so avtomatizirani sistemi odločanja krivični, resnica je lahko tudi drugačna. Celoten kazenskopravni sistem je tam tako zelo krivičen, da ti sistemi to krivičnost dejansko popravljajo. Gre za sistem, ki je zelo rasno in socialno-ekonomsko segregiran. Kar 98 odstotkov zadev se tam danes reši s pogajanji med obtoženim in tožilstvom mimo sodišča. Le dva odstotka ljudi, ki si to – predvsem mislim s tem na velike odvetniške pisarne – finančno lahko privoščita, gresta pred veliko poroto, kakršno vidimo v filmih. Kazenskopravni sistem v ZDA je tako slab, da ga algoritmični sistemi dejansko izboljšujejo, »pametni obrazci« so tam revolucija, ker širijo dostop do pravic.

Potem pa sploh velja vlagati v take sisteme odločanja, bodo dejali njihovi zagovorniki.

Moje vprašanje je, zakaj ne bi raje vlagali v ljudi, namesto da vlagamo v stroje. Dajmo, ukvarjajmo se z ljudmi, ne s stroji, izboljšajmo izobrazbo ljudi, ki bodo potem lahko dobro odločali. Izobražujmo sodnike, ustvarimo razmere za pozitivno selekcijo itn.

Saj vas bodo označili še za ludista – ti so pred več kot sto leti uničevali industrijske stroje, ker so se bali, da bodo zaradi napredka izgubili delovna mesta …

Ta očitek tako ali tako ves čas poslušam. Pa nisem edini. Govorimo o velikih podatkih, t. i. big data, o algoritmih in o umetni inteligenci. Po izobrazbi sem pravnik, in če o teh rečeh govorijo pravniki, to povzroči veliko nervozo pri »podatkovnih znanstvenikih«, češ da ne razumemo, kaj so algoritmi, statistični modeli ipd. Sem raziskovalec družbenega nadzora in sem bil enakih očitkov deležen o neki drugi tehnologiji, o brezpilotnikih, in ob proučevanju kibernetske kriminalitete o računalniških mrežah. Toda to tehnično delovanje ni predmet mojega raziskovanja. Ta kritika vseh, ki ustvarjajo avtomatizirane programe odločanja, je ves čas prisotna, češ da pravniki capljamo za razvojem in ne razumemo točno, za kaj gre – še posebej, kadar smo kritični do učinkov njihovega dela, kot je povečevanje neenakosti v družbi, neetičnega dela in krepitve prav specifičnih elit. A to podatkovnih znanstvenikov ne zanima, to je zunaj njihovega »predmeta proučevanja«.

Umetna inteligenca naj bi bila zaposlenim v pravosodju zgolj v pomoč pri odločanju. Pa vendar si je težko predstavljati policista, tožilca ali sodnika, ki odloči v nasprotju s »predlogom« računalnika, saj je to tako udobno in še odgovornosti se izogne …

Da, to je dejanski učinek teh programov. Privzet način odločanja je tisti, ki ga predlaga algoritem. Za drugačno odločitev je treba vložiti več truda. Vsi pa smo človeška bitja in pogosto ravnamo po liniji najmanjšega odpora. V pravniškem odločanju bi to pomenilo, da bi upoštevali priporočilo, ki ga je pripravil algoritem. Ves čas se govori zgolj o pomoči in priporočilih za odločanje in da vse te programe nadzira človek in tudi človek se potem svobodno odloča, ali bo ta priporočila upošteval ali ne. Dejansko pa to ni res. Bernard Harcourt je recimo opravil raziskave med sodniki in ti so večinoma upoštevali priporočila računalniških programov in v bistvu jim to tudi zelo ustreza in nimajo nič proti temu. S tem je njihovo delo lažje, pa še odgovornosti se razbremenijo oziroma se ta odgovornost porazdeli z enega človeka, sodnika, na več ljudi, na pravosodno ministrstvo, ki je odločilo, da se ti sistemi uporabljajo, na ustvarjalce računalniških programov in šele na koncu tudi na sodnika.

Kazenskopravni sistem v ZDA je tako slab, da ga algoritmični sistemi dejansko izboljšujejo, »pametni obrazci« so tam revolucija, ker širijo dostop do pravic.

Marsikdo si morda želi, da bi tehnološki napredek prinesel napredek pri varnosti, ki je zadnja leta pomembna tema.

Veliko podatko vje in algoritmi prinašajo spremembe glede tega, kako konceptualiziramo svet. Profesorica Louisa Amoore recimo pravi, da je od dogodkov 11. septembra, ki so bili točka preloma v ukvarjanju z varnostjo, v varnostnem diskurzu zelo cenjen predvsem matematični jezik, ki je prinesel nov način osmišljanja varnostnih vprašanj. V kazenskem pravu smo imeli v preddigitalnem času koncepte nedolžnega, obtoženega in obsojenega, po novem pa imamo opravka z verjetnostjo, »spečimi teroristi« itn. Ta novi jezik ruši temeljne institute in koncepte liberalnega kazenskega postopka. Gre za težko vprašanje, kdaj kdo velja za »domnevnega« terorista« in kdaj naj se represivni organi osredotočijo nanj.

Oziroma kako preprečiti zločin, preden se zgodi?

Da. Šolski primer tega je bila nemška zakonodaja, kjer so uvedli koncept »spečega terorista«. Morda še on ne ve, da je terorist, v njem ždi terorist, a po algoritmičnem izračunu in rudarjenju po velikih količinah raznovrstnih podatkov je že primerna tarča nadzora, nanj se morajo usmeriti obveščevalne in varnostne službe. Parametri, ki ga delajo za spečega terorista, pa so recimo, da je samski moški, da plačuje z gotovino in tako naprej … Nemško ustavno sodišče je kasneje presodilo, da je to nedoločen pojem in zato ne more biti del kazenske zakonodaje. Vnašanje teh novih, nedoločnih pojmov v kazensko zakonodajo, ki se nanašajo na zelo zgodnje pripravljalne faze kaznivih dejanj, ruši osnovne koncepte v kazenskem pravu, domnevo nedolžnosti, pogoje za obtožnico, kjer mora biti velika verjetnost, da si storil kaznivo dejanje, in obsodbo, ki je mogoča le, če je dejanje dokazano prek razumnega dvoma.

Imamo podjetja, ki so razvila algoritme, ki na podlagi poprejšnjih sodb izračunajo, ali bo neka tožba uspešna ali ne, in če algoritem pokaže, da bo, krijejo stroške tožbe tožnikov, seveda v zameno za poplačilo stroškov in storitve iz dosojene odškodnine.

Da, in tako podjetje ima v vsakem primeru dobiček. Primera, ki ne bo uspel na sodišču, sploh ne prevzame.

Četudi se posamezniku dejansko godi krivica, sploh nima več možnosti, da bi dosegel popravo na sodišču, če algoritem ne ugotovi verjetnosti za zmago?

Da, ta nova tehnologija za osmišljanje velike količine podatkov pač podpira interese tistih, ki si jo lahko privoščijo. Utopično bi bilo pričakovati, da bo ta tehnologija sama po sebi omogočala doseganje pravičnejših ciljev. Podpira veljavni sistem, to pa je sistem neoliberalnega razslojevanja in razpiranja škarij med bogatimi in revnimi in to je glavni očitek pri rabah te tehnologije.

Med očitki algoritmom je treba posebej omeniti poglabljanje rasne segregacije.

Podjetje Northpoint, ki je izdelalo algoritem za ocenjevanje ponovitvene nevarnosti obsojencev COMPAS (Correctional Offender Management Profiling for Alternative Sanctions), pomaga pri odločanju o pogojnem odpustu v številnih zveznih državah v ZDA. A raziskovalci ProPublice so dokazali, da je algoritem rasno pristranski, saj izračuna, da je verjetneje, da bo temnopolti ponovil kaznivo dejanje, čeprav ga v resnici ne. Belopolte pa računalnik pogosteje spozna za neproblematične, čeprav potem ponovijo kaznivo dejanje. V programu je različna utež za pripadnike različne barve polti.

Ampak odgovorni v politiki bodo rekli, da je res tako, da statistični podatki to potrjujejo in da je utež dobra.

Da, ves čas trdijo, da ne ustvarjajo resničnosti, ampak le preslikavajo položaj v družbi. Moj očitek temu je, prav, ampak čemu so potem namenjeni ti sistemi, neskončni perpetuaciji rasne segregacije? Naloga sodnika je oziroma bi morala biti ravno, da rasne predsodke korigira. Saj želimo družbo narediti boljšo ali si želimo samo obdržati status quo? Odvisno seveda, koga vprašamo.

Če segregacijo iz ZDA preslikamo v Slovenijo, bi algoritem pač določil pripor za Roma, čeprav je nedolžen, ne pa za pripadnika večinskega naroda, čeprav je kriv. Neki tak program naj bi kmalu namreč dobila tudi slovenska služba za probacijo …

Sem prepričan.

Bodo, če se bova pogovarjala čez dvajset let, že vsi v pravosodnem sistemu uporabljali algoritmično »pomoč« pri odločanju?

Ne vem, mislim pa, da bo dejansko veliko odločanja v pravosodju in širše v javni upravi podprtega z algoritmi. In sicer zato, ker je veliko interesov, da se to zgodi, in tega ne bomo preprečili.

To pa bo že pomenilo, da dejansko v pravosodju odločajo algoritmi in ne ljudje.

Tako je. A vendar je tudi v pravosodju treba razlikovati med različnimi postopki in opravili. Vsaj odločanja o krivdi ne moremo ali ne bi smeli nikoli prepustiti avtomatiziranim »črnim škatlam«. Po mojem mnenju je recimo odločanje o pogojnem odpustu v Sloveniji preveč arbitrarno. Vsi pristojni lahko podajo soglasje v konkretnem primeru pogojnega odpusta, ki je zaradi tega dokaj upravičen, a komisija lahko preprosto odloči drugače in pogojni odpust iz zapora zavrne. Merila odločanja so zelo ohlapna, gre za en sam zakonski razlog, ki je vsebinsko zelo nedoločen. To se mi ne zdi v redu.

Bi bil pri tem dobrodošel računalniški program kot pomoč komisiji?

Ko je dovolj slabo, tudi računalniški program pomaga. Primerjalno bi bila pravičnost večja, ker bi odločitev temeljila na bolj objektiviziranih parametrih, ne zgolj na enem kakor sedaj. Podobno kot imamo že merila, sodno prakso, ki je napolnila vsebinsko prazen pojem »ponovitvene nevarnosti«. Kakor sem že rekel, če so postopki v kazenskem pravu dovolj slabi, jih algoritmi lahko poboljšajo. In glede pogojnega odpusta je že tako. Tak program je tudi nekaj povsem drugačnega kot verjetno najbolj nora raziskava o rabi algoritmov za prepoznavanje kriminalnosti z obraza. Skratka, imamo pametne stroje, ki se na doslej obsojenih kriminalcih učijo, kakšen je obraz kriminalca, in se naučijo ločevati med obrazi kriminalcev in obrazi nedolžnih. Ta raziskava je karikatura celotnega algoritmičnega odločanja, povezanega s kazenskim pravosodjem. Raziskovalci, ki so jo opravili oziroma so ustvarili ta program, mislim, da so iz Kitajske, trdijo, da je prepoznavanje kriminalnosti z obrazov dejansko mogoče. Meni se zdi noro, da se kdo sploh spomni česa takega.

Noro? Za ustvarjalce programa, ki ga bodo gotovo ponujali na trgu in z njim tudi zaslužili, ni v tem prav nič norega.

Seveda. A tu gre za zamisel o branju normativnosti iz biologije, v tem primeru s človeških obrazov, za mešanje dveh ločenih ravni. Eno so narava in naše obrazne poteze, drugo je normativnost, kaj je prav, kaj je narobe, kaj je dobro in kaj slabo. Trdijo, da lahko normativnost prepoznajo na telesu. Imeli smo Lombroza, evgeniko in potem nacizem. To je to, na telesu razbrati, kdo je slabši in kdo boljši, katera rasa je slabša in katera boljša. Na tem področju gledamo zlorabe v vsej človeški zgodovini.

Pojavljajo se tudi opozorila, da bi morali zaščititi zasebnost v svoji glavi, kot smo jo recimo pri zasebnosti stanovanja …

Skrb je, da ta realnost že dolgo obstaja v marketingu. Na tem temelji Amazon ali pa iskalnik Google recimo, in sicer, da dobivaš zadetke, ukrojene na podlagi preteklih iskanj, njihov argument je, da so izboljšali uporabniško izkušnjo. Da skratka dobimo tisto, kar nas zanima, in ne tistega, kar nas ne. To se seveda zdi smiselno, a ta logika iz marketinga vstopa v proces političnega odločanja.

Program, ki je »sposoben« razlikovati med obrazi kriminalcev in obrazi nedolžnih, je karikatura celotnega algoritmičnega odločanja, povezanega s kazenskim pravosodjem.

Kako se to kaže?

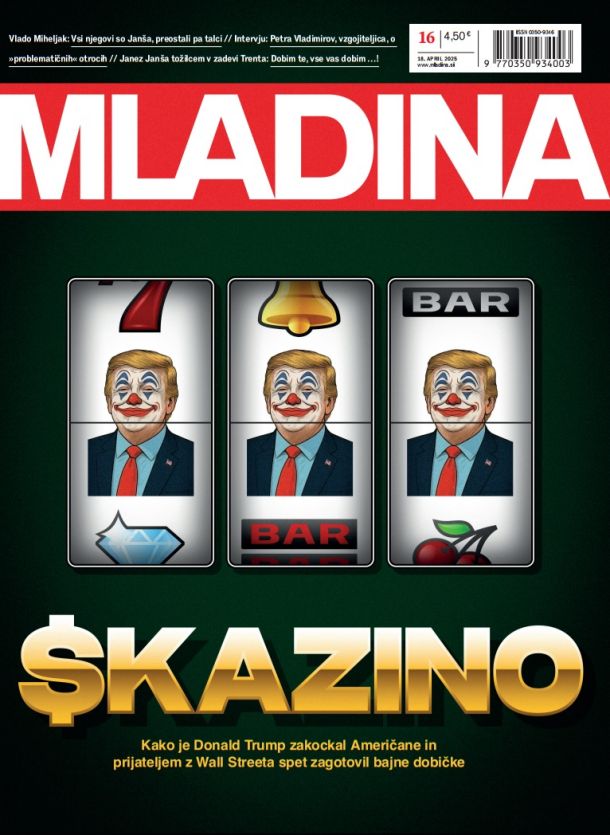

En način je »micro targeting« oziroma mikrotarčno naslavljanje volivcev, torej ukrojena sporočila posameznemu volivcu, čemur smo bili priča pri predsedniških volitvah v ZDA in kampanji predsedniškega kandidata Donalda Trumpa. Podjetje Cambridge Analytica trdi, da je imelo 700 oziroma celo pet tisoč podatkov o vsakem volivcu in da je lahko targetiralo volivce z ukrojenimi oglasi. Recimo republikanske volivce z domoljubjem, demokrate s spoštovanjem prava in človekovih pravic … Učinek ni v tem, da nekdo potem voli Trumpa, ampak da gre na volitve ali ne, da skratka neopredeljene potisne za milimeter ali dva v eno ali drugo smer. Da je to mogoče narediti, dokazujejo znanstveniki iz Facebooka, ki so že pred štirimi leti objavili, da so sposobni pri Facebooku izpeljati »čustveno okužbo« uporabnikov. Spremenili so razpoloženje 800 tisoč uporabnikom, ne da bi se ti tega zavedali. Recimo tako, da so sporočila postajala bolj depresivna, negativna in da so uporabnike potisnili v eno smer. Drugi način je prek spletnih iskalnikov, kjer so možnosti izredne. Vzemimo nekoga, ki na Googlu išče kaj o zdravju in potem začne dobivati Trumpove govore o zdravstvenem sistemu, kaj vse je treba drugače narediti, izboljšati … Enako je glede šolstva in vseh drugih mogočih tem. Na podlagi posameznikovega iskanja mu lahko ponudimo govore politika o tej temi, politik pa je seveda govoril o vseh stvareh.

Zakaj je vse to sporno? Bolj obveščena družba je boljša od manj obveščene, bi gotovo rekli zagovorniki novih tehnologij.

Vstop mikrotargetiranja iz trženja izdelkov v proces političnega odločanja je sporen, ker pomeni, da bo tisti, ki si lahko privošči podatkovne analitike, zmagal na volitvah. Tako lahko dejansko kupiš volitve. Recimo temu »predsedniški algoritem«. V neki afriški državi storitev prodajo tistemu, ki ponudi več za podatkovno analitiko, in mu zagotovijo izvolitev. Morda je to preradikalno. A raba podobne podatkovne analitike v politiki že poteka v obliki digitalne volilne geometrije (angl. digital gerrymandering). To pomeni, da si s spreminjanjem meja volilnega okrožja zagotoviš zmago. V tej državi imaš recimo stranko, ki ima 40-odstotno javnomnenjsko podporo, in stranko s 60-odstotno podporo in z začrtanjem meja volilnih okrožij zagotoviš, da stranka s 40-odstotno podporo dobi več kot 50-odstotno podporo in zmaga na volitvah. Novi modeli podatkovne analitike omogočajo, da se na podlagi množice podatkov o volivcih naredijo številne simulacije in glede na najboljšo za izbrano stranko se potem propagirajo »pravično« postavljene meje volilnih okrožij v državi. V ZDA se razmišljanje o tem pojavlja že od leta 2014. Gre za »digitalno volilno geometrijo«, kot jo je imenoval profesor Jonathan Zittrain, ki pomeni, da meja volilnih okrožij ne spreminjaš več fizično, pač pa recimo Facebookovim uporabnikom serviraš podatke, kako so volili njihovi »pomembni drugi« in ali so sploh volili, in s tem, da se jim to prikazuje, potisneš volilno telo v eno ali drugo smer. Če so tvoji »bližnji« šli na volitve oziroma volili nekoga, je zelo verjetno, da boš ti storil enako. To so dokazali s poskusom, s katerim so mobilizirali 60 tisoč volivcev, da so šli sploh volit, na podlagi tega je potem še 340 tisoč volivcev potencialno mobiliziranih zaradi verižne reakcije. To so te mikrospremembe na individualni ravni, ki pa na koncu na agregatni ravni pomenijo ločnico med porazom in zmago na volitvah. Potem lahko govorimo, da demokracije ni več, pač pa imamo »algokracijo«, torej nimamo več vladavine prava, ampak vladavino algoritmov.

Poglejva v daljno prihodnost. Se nam bo zgodilo kaj takega kot v filmih Matrica, bo umetna inteligenca nazadnje prepametna, da bi jo človek še lahko obvladoval?

Tega ne vem. Vem pa, da se že pojavljajo opozorila, da je umetno inteligenco treba omejevati, regulirati. Mednarodna skupina raziskovalcev umetne inteligence, ki so jo podprli tudi nekateri člani slovenske SAZU, se je pred dvema letoma zavzela za sprejetje mednarodne konvencije o prepovedi napadalnega avtonomnega orožja. Povedano drugače, gre za svarilo pred orožjem, ki ti »frankensteinsko« uide izpod nadzora.

Pisma bralcev pošljite na naslov pisma@mladina.si. Minimalni pogoj za objavo je podpis z imenom in priimkom ter naslov. Slednji ne bo javno objavljen.