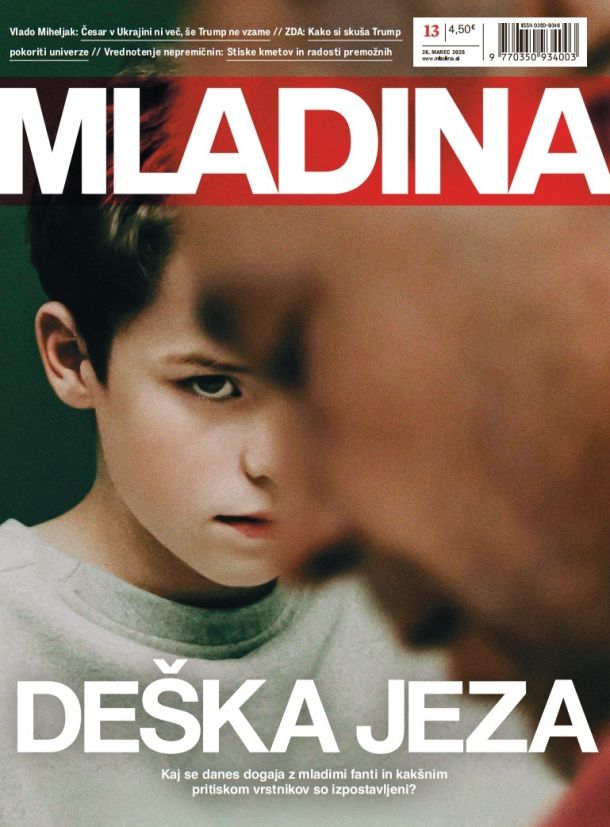

7. 7. 2023 | Mladina 27 | Družba | Intervju

Filip Dobranić / »Kapitalistom ustreza, da si slabe življenjske pogoje pojasnjujemo s prihodom nekega novega stroja«

Sociolog kulture, filozof in programer

© Luka Dakskobler

Filip Dobranić (rojen leta 1989) je sociolog kulture, filozof, programer in heker. V srednješolskih letih je bil dvakrat ovenčan kot svetovni prvak v debatiranju, v času študija je soustanovil aktivistično spletno platformo in inštitut Danes je nov dan, zaposlen pa je na Inštitutu za novejšo zgodovino. Je ena tistih redkih ptic, ki podrobno poznajo tehnično plat raznih visokotehnoloških pogruntavščin – med drugim je doktorski kandidat na Fakulteti za računalništvo in informatiko v Ljubljani –, a se sočasno poglobljeno ukvarjajo z družbenimi vprašanji in etičnimi dilemami, ki jih odpirajo nove tehnologije. Za Mladino je tokrat spregovoril o izzivih in pomislekih, ki jih prinaša vzpon umetne inteligence.

Vaš odnos do razvoja umetne inteligence se zdi precej prizemljen.

Zakup člankov

Celoten članek je na voljo le naročnikom. Če želite zakupiti članek, je cena 4,5 EUR. S tem nakupom si zagotovite tudi enotedenski dostop do vseh ostalih zaklenjenih vsebin. Kako do tedenskega zakupa?

7. 7. 2023 | Mladina 27 | Družba | Intervju

© Luka Dakskobler

Filip Dobranić (rojen leta 1989) je sociolog kulture, filozof, programer in heker. V srednješolskih letih je bil dvakrat ovenčan kot svetovni prvak v debatiranju, v času študija je soustanovil aktivistično spletno platformo in inštitut Danes je nov dan, zaposlen pa je na Inštitutu za novejšo zgodovino. Je ena tistih redkih ptic, ki podrobno poznajo tehnično plat raznih visokotehnoloških pogruntavščin – med drugim je doktorski kandidat na Fakulteti za računalništvo in informatiko v Ljubljani –, a se sočasno poglobljeno ukvarjajo z družbenimi vprašanji in etičnimi dilemami, ki jih odpirajo nove tehnologije. Za Mladino je tokrat spregovoril o izzivih in pomislekih, ki jih prinaša vzpon umetne inteligence.

Vaš odnos do razvoja umetne inteligence se zdi precej prizemljen.

Želite reči ciničen?

No, pa reciva ciničen. Zdi se mi, da v to tehnologijo ne polagate prevelikih upov, posledično pa ste skeptični tudi do raznih obljub pogube, ki spremljajo njen razvoj. Zakaj so ti upi in strahovi po vašem mnenju tako prenapihnjeni?

Prenapihnjeni so, ker nekdo z njihovo pomočjo skuša ustvarjati dobiček. Podobne napovedi in reklame, kot jih opažamo danes, smo videli že v sedemdesetih letih. Ne nazadnje je film 2001: Odiseja v Vesolju, ki kljub svoji površinski kritiki verjame v skorajšnji prihod »umetne inteligence«, izšel že leta 1968. V sedemdesetih letih je po veliko neizpolnjenih obljubah sledila t. i. »zima umetne inteligence«, ko je količina investicij v razvoj te tehnologije strmo padla.

Tovrsten marketing pogosto uporabljajo tehnološka podjetja, ki jih poganja tvegani kapital iz Silicijeve doline, kjer vlagajo predvsem v »hype« (pomp, op. p.). Kot vlagateljica tveganega kapitala (venture capitalist, op. p.) nekomu daš na primer milijon dolarjev zato, da boš nekega dne iz tega zaslužila sto milijonov, saj z vsako naložbo ciljaš na vsaj desetkratni zaslužek, včasih pa tudi na stokratni ali tisočkratni. Ravno zato je za vlagatelje popolnoma sprejemljivo, da gre devet od desetih naložb k vragu: ker so stave tako visoke, se lahko izide le ena, pa so svoj sklad že poplačali. Za možnost, da bi katerakoli investicija ustvarila stokratni dobiček, pa se morajo vsi ti kapitalisti nenehno pretvarjati, kot da bo tako uspešen čisto vsak projekt, v katerega vložijo.

Ko so z neba padala prva letala ali ko so prvi ljudje umirali zaradi novih cepiv, je bilo takrat to veliko bolj dramatično kot v primeru, ko je prvi samovozeči avtomobil nekoga povozil, saj teh zadev nismo bili sposobni normalizirati, preden jim je prvič spodletelo.

Tako imenovana »A. I. revolucija« je torej umetno ustvarjen pomp, ki obljublja nemogoče?

Mislim, da ga velja primerjati z ostalim oglaševanjem. Če si zelo priden in discipliniran, boš verjetno shujšal, če boš pridno telovadil, boš verjetno postaven, vsekakor pa ne bo dovolj, če boš samo pil proteinske napitke. Obljube oglasov za prehranska dopolnila so velikokrat potencirane do skrajnosti in ne predstavljajo tistega, kar lahko od njih dejansko pričakujemo – da niti ne omenjamo problema prevelikega vnosa beljakovin, ki nam lahko nakoplje putiko. Umetno inteligenco spremlja vsaj toliko pompa, kolikor ga je denimo pri zdravilih. Naj v tem kontekstu podam absurden primer: pri nas reklamirajo analgetik, kjer bolečino pooseblja gospod z vrtalnikom: sporočajo, da je ta analgetik tako učinkovit, da bo z nami vse v redu, tudi če nam bo nekdo z bormašino povrtal v glavo.

Vsi naj bi razumeli, da je to karikirano in naj bi bilo humorno, ampak konec koncev gre za zavajajočo implikacijo.

Pred petimi, desetimi leti – tega sem kriv tudi jaz – smo napovedovali, da so samovozeči avtomobili tako rekoč za vogalom. Takrat je ogromno ljudi prodajalo zgodbo, da kar naenkrat ne bomo več potrebovali tovornjakarjev in tovornjakaric, danes pa živimo v svetu, ko jih imamo premalo. Verjetno ne zato, ker bi se ljudje odločili, da ne bodo šli v poklic, ki bo čez deset let izumrl. Zdaj vemo, da so bile te napovedi popolnoma napačne, so pa zagotovo oslabile pogajalsko pozicijo tovornjakaric. Podobno se dogaja zdaj, ko nekateri napovedujejo, da zaradi ChatGPT-ja ne bomo več potrebovali odvetnic, kar je seveda popolnoma zgrešeno.

Vseeno pa je ChatGPT, četudi je šele na začetku »kariere«, uspešno opravil pravosodni izpit.

Kot pr a vi libanonski mislec N assim Nicholas Taleb: »You need to have skin in the game«, torej »imeti moraš vložek v tej igri«. Ko algoritem uspešno reši test za pridobitev odvetniške licence, to še ni »skin in the game« situacija, saj nihče ne more dobiti po nosu. Ko pa neki odvetnik na sodišču dejansko vloži izmišljene sodne primere, ki jih je pridobil z uporabo ChatGPT-ja, ima to seveda resne posledice. Ta odvetnik se načeloma lahko izgovarja, da ga je ChatGPT zavedel, a če kot odvetnik na sodišču lažeš o primerih, ki jih dejansko nikoli ni bilo, je to dober razlog za odvzem odvetniške licence.

Če pod vplivom alkohola povoziš človeka, je to razlog za odvzem vozniškega dovoljenja. Po drugi strani pa podjetja, ki razvijajo samovozeče avtomobile, dovoljenja za vožnjo po javnih cestah ne izgubijo, tudi če so njihovi avtomobili koga povozili. Tukaj je velika napetost, saj po eni strani vztrajno dajejo velike obljube, ki jih enostavno ne morejo izpolniti, po drugi strani pa so to korporacije, ki jih obravnavamo bolj prizanesljivo kot ljudi, čeprav bi, jasno, morali biti do njih strožji.

Pretkan marketing podjetjem omogoča, da razvoj teh tehnologij vežejo na imaginarij, ki smo ga zgradili skozi knjige in filme, kot na stvari, ki jih že uporabljamo, denimo na avtomobile, saj s tem zmanjšajo eksotičnost, ki nove pogruntavščine dela bolj strašljive. Ko so z neba padala prva letala ali so prvi ljudje umirali zaradi novih cepiv, je bilo takrat to veliko bolj dramatično kot v primeru, ko je prvi samovozeči avtomobil nekoga povozil, saj teh zadev nismo bili sposobni normalizirati, preden jim je prvič spodletelo. Ko samovozeči avtomobil povozi kolesarja, ne zganjamo hude moralne panike. Pri tem pa ne smemo pozabiti, da se s samovozečimi avtomobili vozi veliko manj ljudi, kot je cepljenih s cepivom proti covidu.

Interna šala med raziskovalci pravi, da je umetna inteligenca vse tisto, kar še ne deluje. V trenutku, ko neki algoritem postane zanesljiv, ko ga znamo kakovostno operacionalizirati, dobi konkretno poimenovanje.

Ker ste v desetih letih spremenili stališča glede samovozečih avtomobilov, me zanima, kako se je vaš pogled na umetno inteligenco spremenil v zadnjih letih, odkar so prah začeli dvigovati ChatGPT in njemu podobni programi. Kam se je premaknil fokus vaših razmislekov?

Ker sem v teh razmislekih pogosto kritičen, moram najprej poudariti, da nimam nobenih težav z raziskovalkami in raziskovalci. Naj trenirajo te modele, naj jih preizkušajo, naj počnejo, karkoli se jim zdi etično in potrebno za nadaljnji razvoj znanosti. Težave se pojavijo, ko plodovi njihovih raziskav postanejo produkt, ko začnejo prodajati velike zgodbe. Takrat nastopi pravi trenutek za začetek iskanja odgovornosti. Resnično ni kriv prvi raziskovalec, ki je zgradil veliki jezikovni model.

Pomembno je tudi, da se pogovorimo o jeziku, ki ga uporabljamo pri razpravah o umetni inteligenci in tehnologijah v tem okviru. Osebno ne maram izraza »umetna inteligenca«: ko in če bo umetna inteligenca dejansko postala inteligenca, ne bo več umetna, saj bo pač inteligenca. Ali je inteligenca ali pa ni. Meni je ljubši izraz »strojna inteligenca«, saj jasneje namigne, da gre za delo, ki ga opravlja stroj.

Tudi poimenovanje »velikih jezikovnih modelov« je ponesrečeno, saj ti sistemi modelirajo tekst, ne jezika. Ključna razlika je, da resničnost jezika vselej vključuje subjekt: nekoga, ki govori, bere, posluša. Subjektivnost nečesa ali nekoga je sestavni del vsakega jezikovnega dejanja, tekst pa je nekaj, kar ne potrebuje subjekta, je le produkt jezikovne aktivnosti. Ti stroji modelirajo tekst, ne jezika, in ko do njih pristopamo s tem vedenjem, nam postanejo jasnejše tudi njihove omejitve, posledično pa si lažje ustvarimo tudi bolj realistična pričakovanja, povezana z njimi. Interna šala med raziskovalci pravi, da je umetna inteligenca vse tisto, kar še ne deluje. V trenutku, ko neki algoritem postane zanesljiv, ko ga znamo kakovostno operacionalizirati, dobi svoje poimenovanje – in vsi ga začnemo imenovati s tem konkretnim terminom, medtem ko je umetna inteligenca vse ostalo, kar »še ne deluje«.

Umetna inteligenca je torej kot premikajoča se tarča, ki ji težko sledimo.

Z izrazom »umetna inteligenca« pogosto namigujemo na to, kar naj bi bila »splošna umetna inteligenca«, ki je pravzaprav ne znamo dobro opisati, a če posplošim, naj bi šlo za poustvaritev tega, kar ljudje čutimo kot lastno inteligenco. Splošna umetna inteligenca (AGI) je dolgoročni cilj razvoja umetne inteligence, a neka druga interna šala med raziskovalci pravi, da smo od njenega izuma vselej oddaljeni dvajset let.

Če želimo verjeti v možnost obstoja »splošne umetne inteligence«, moramo verjeti v neodvisnost inteligence od substrata, torej izhodne snovi. Tako kot mora roža zrasti iz zemlje, potrebuje tudi inteligenca svoj substrat. Trenutno vemo, da naša inteligenca deluje na biološkem substratu, nihče pa še ni ponudil odgovora na vprašanje, ali je inteligenca neodvisna od izhodne snovi, ali lahko torej vznikne na kamnu, na plastiki ali kjerkoli drugje. Nekateri filozofi precej prepričljivo zagovarjajo tezo, da bo to, kar želimo osmisliti kot inteligenco, moralo imeti neko slo po življenju, neko lastno motivacijo za izvedbo naslednjega cikla računanja. Ta motivacija je za zdaj seveda vselej zunanja: kot raziskovalec ali programer kliknem na gumb in s tem poženem sistem, ki pa sam po sebi nima interne motivacije.

V radijski oddaji Intelekta ste rekli, da generativna umetna inteligenca ni zares nič novega, da ljudje podobne rezultate dosegamo z uporabo programov, kot je denimo Photoshop. Lahko to očitate tudi velikim jezikovnim (oziroma tekstovnim) modelom, na primer ChatGPT-ju?

Mogoče sem se malo ponesrečeno izrazil. Ta izjava je resnična predvsem v razmerju do družbe: ne verjamem, da Midjourney lahko vodi v velike družbene spremembe. Da se bomo zaradi Midjourneyja in njemu podobnih programov znašli v poplavi lažnih fotografij, ki bodo ogrozile demokracijo, se mi ne zdi ravno prepričljiv argument, saj resnično ni treba biti ne vem kako bogat, da lahko dobiš vse lažne fotke, ki jih želiš. Zadostna vsota denarja ti kupi dovolj ur kateregakoli oblikovalca, ki ti lahko ustvari, karkoli pač želiš, zato učinek programov, kot je Midjourney, res ne bo tako velik, kot jim ga pripisujemo. S tega vidika tudi veliki tekstovni modeli sami po sebi ne bodo pomenili revolucije, četudi bodo vplivali na to, kako so videti naše službe in kaj vse počnemo na delovnih mestih.

Kar želimo osmisliti kot inteligenco, bi moralo imeti neko slo po življenju, neko lastno motivacijo za izvedbo naslednjega cikla računanja. Ta motivacija je za zdaj seveda vselej zunanja: kliknem na gumb in s tem poženem sistem, ki pa sam po sebi nima interne motivacije.

Kapitalistom bi ustrezalo, da postanemo ludisti, ki si množično izgubo služb in slabe življenjske pogoje pojasnjujejo z obstojem nekega novega stroja. A pravzaprav stroj ni tisti, ki nas prikrajša za plačo. To so šefi in lastniki. Vprašanje dostojanstva naših življenj ni odvisno od tehnologije, ki prevladuje ali bo prevladovala. Seveda je popolnoma normalno, da se ljudje na vzpon umetne inteligence instinktivno odzivajo s strahom pred izgubo služb. To kaže, kaj jih ogroža. Ko se pojavi neka nova tehnologija, ljudje ob tem prepoznajo predvsem tveganja, ki najbolj zadevajo njih osebno. Ne razmišljajo o širših družbenih posledicah, ne razmišljajo, kaj bo to pomenilo za planet. Razmišljajo predvsem, kaj bo to pomenilo za njihovo službo, saj so psihično in eksistenčno najbolj odvisni od zaposlitvenega statusa.

Zakaj pa se zaradi vzpona generativne umetne inteligence počutijo tako ogroženi razni ustvarjalci? Poglejva denimo aktualno stavko scenaristov v Hollywoodu: ob opozarjanju na slabe honorarje v dobi pretočnih platform protestirajo predvsem proti uporabi umetne inteligence v produkciji filmov in serij.

Gre za obliko prvotne akumulacije kapitala. Piske in druge producentke kreativnih vsebin so trenutno zaščitene z avtorskim pravom. Ne verjamejo, da lahko na podlagi zdajšnje avtorskopravne zakonodaje preprečijo uporabo svojih del za treniranje novih modelov. Ker ne tržijo svojih ur, temveč produkt svojega dela, želijo preprečiti, da bi umetna inteligenca proizvajala dela, ki so zaščitena z avtorsko in sorodnimi pravicami. Če bodo veliki tekstovni modeli zares postali pomembni, bodo lastniki kapitala de facto razlastili trenutne lastnike avtorskih pravic.

Kaj bi se zgodilo, če bi kreativne industrije posvojile uporabo teh algoritmov? Verjetno bi se začelo s tem, da bi ustvarjalcem porezali denimo 10 % honorarja pod pretvezo, da jim je umetna inteligenca olajšala delo, a pravzaprav bi bili zaradi nje pod še večjim pritiskom. Podobno se zgodi, ko ti v službi vsilijo neko novo programsko opremo, za katero si prepričan, da ti ne bo olajšala življenja, bo pa šefu dala dober izgovor, da ti naloži še več dela. Njihovo stavko razumem predvsem iz te perspektive in ne kot upora proti tej konkretni tehnologiji. Stavka ima podlago ne glede na to, ali je tehnologija ta trenutek koristna ali ne, saj si scenaristi želijo zagotoviti, da bodo obdržali vir prihodka.

Prav tako bi bil produkt, ki bi ga ustvarila umetna inteligenca, na neki način le recikliran kolaž del prav tistih ustvarjalcev, ki protestirajo, kajne?

Takoj ko se je pojavila prva verzija slikarskega robota DALL-E, so nekateri umetniki začeli problematizirati, da umetna inteligenca imitira njihov slog. Takrat jim je bilo relativno enostavno kljubovati. Vsi so rekli: »Pa dobro, glej, kako slabo to dela, zakaj bi se kdorkoli pritoževal …« Žaba se je nato počasi skuhala. Danes ta orodja delujejo veliko bolje, kar sproža vse glasnejše krike.

Na tej točki velja omeniti tezo, da če novo iteracijo velikega tekstovnega modela treniraš na produktih prejšnje iteracije nekega drugega velikega modela, začne kakovost tega modela močno padati. Po nekaj krogih začnejo modeli proizvajati besedila, ki so sicer na prvi pogled videti, kot da vsebujejo smiselne povedi, vendar te nimajo več nobenega vsebinskega smisla. V nekaj korakih dobiš popoln zmazek. Tu se pojavi velik problem, saj je na spletu čedalje več vsebine, ki je generirana z velikimi tekstovnimi modeli. Tega ta trenutek najverjetneje ni mogoče zaustaviti. Morda se bomo znašli v situaciji, ko bodo teksti z interneta, ki so nastali pred letom 2021, kot medicinska kovina izpred druge svetovne vojne, ki ni okužena z radiacijo, praktično neobnovljiv vir, s katerim je treba zelo pazljivo ravnati.

Če prav razumem, pa se ti modeli ne učijo zgolj prek analize velikih podatkovnih baz, temveč tudi prek naše interakcije z njimi. Zdi se, da tu delamo podobno napako kot pri uporabi družbenih omrežij, kjer svoje dragocene podatke prostovoljno razdajamo korporacijam.

Temeljni problem je, da je ta orodja ustvarilo zasebno podjetje. Na trg je izstrelilo produkt, ki kopiči rezultate tvojega dela in jih uporablja za kovanje zasebnih dobičkov. Uporabnice in uporabniki posledično opravljajo neplačano delo. Torej, vsi ti »pogovori« so shranjeni, oni bodo na njih trenirali ali pa ne, odločitev bo njihova. To ni nekaj, v čemer smo vsi skupaj udeleženi in od česar bomo vsi imeli neko korist. Gre za situacijo, v kateri mi nekaj prinesemo baronu v grad, odkorakamo iz njegove graščine in prekrižamo prste v upanju, da se s temi stvarmi ne bo zgodilo nič slabega – oziroma da bodo pravično razdeljene med ljudi.

Zakaj se po vašem mnenju podjetja, kot je OpenAI, tako zelo izogibajo transparentnosti svojih operacij?

Gre za logiko poslovnih skrivnosti. Skrivajo stvari, ki jih trenutno ločijo od konkurence. A pravzaprav o tem, kako točno njihovi modeli delujejo, vemo zelo malo. Vemo, da je v njih »ves internet«, med narekovaji seveda. Na internetu pa je ogromno groznih stvari, ki jih verjetno ne bi želeli reproducirati. Ne vemo zares, kako točno so oni poskrbeli za te stvari in koliko so jih izločili oziroma filtrirali. Ne smemo pozabiti niti, da je nekdo moral gledati grozne stvari zato, da jih je lahko izločil iz tega modela. Če bi neka tovarna, denimo Lek, svoje odpadke vozila na obrobje neke vasi v Prekmurju, kjer bi morali ljudje, ki boljše službe ne najdejo, ta strup cele dneve prekladati, bi bila verjetno javnost precej ogorčena.

Že mnogi Facebookovi moderatorji, ki filtrirajo žaljivo, nevarno in nazorno vsebino, naj bi trpeli zaradi posttravmatske stresne motnje. So v podobni koži tudi tisti, ki trenirajo sisteme umetne inteligence?

Da lahko ti produkti sploh obstajajo, mora nekdo kopati po gnoju, kar ima lahko hude psihološke posledice, navadno pa to počnejo prav najšibkejši in najbolj deprivilegirani. Da lahko modelu poveš, da je nekaj neprimerna vsebina, mora to najprej pogledati oseba in stvar označiti kot neprimerno. Ni drugega načina. Preden se začne strojno filtriranje, moraš v model vnesti na stotine, če ne tisoče primerov. Lahko se sicer zanašaš, da pri večini javnih storitev tovrstnih vsebin ni, ampak ker hočeš čim več različnih podatkov, zajemaš z zelo široko mrežo, posledično pa se vanjo ujame marsikaj, česar ne želiš reproducirati.

Kaj pravzaprav mislimo, ko rečemo, da je umetna inteligenca pristranska?

Večina modelov deluje tako, da pogledajo ogromno stvari in si shranijo neke njihove lastnosti. Ne vemo točno, kako so te lastnosti strukturirane, kako zelo abstraktne so, vemo pa, da se modeli učijo tako, da ustvarijo neke osnovne gradnike. Ves sistem temelji na posplošitvah, zadeve pa lahko posplošiš le tako dobro, kolikor so dobri podatki, na podlagi katerih si posplošitve delal. Svet je rasističen, tako kot je rasistična kultura, ti modeli pa se lahko učijo le preko analize kulturnih produktov – če torej t. i. učne množice ne bomo pazljivo kurirali, bodo modeli reproducirali obstoječi družbeni red.

Akt o umetni inteligenci, ki ga pripravlja Evropska unija, skuša omejiti »pristranskost« in nadzorno uporabo sistemov umetne inteligence, predvsem sistemov za biometrično identifikacijo. Se s temi prioritetami strinjate, morda akt pozablja na kaj še pomembnejšega?

Omejitve seveda pozdravljam. Poudaril pa bi, da je Evropski parlament zamudil priložnost za zaščito pravic migrantov, ki so verjetno najpogostejša tarča diskriminatornega tehnološkega razvoja. Evropska unija očitno podpira nekakšen panoptikon na lastnih mejah, ki migrantom ne zagotavlja enakega nabora človekovih pravic kot prebivalcem unije.

Ko se pojavi neka nova tehnologija, ljudje ob tem prepoznajo predvsem tveganja, ki najbolj zadevajo njih osebno. ne razmišljajo o širših družbenih posledicah, ne razmišljajo o tem, kaj bo to pomenilo za planet.

Glede policijske rabe tehnologij za biometrično identifikacijo so argumenti zelo slabi. Začnimo s tem, da nekdo pokaže, da ta tehnologija dela naše prostore varnejše. Kolikor je meni znano, za zdaj ni čudovitih dosežkov, po drugi strani pa so kar nekaj ljudi po krivem kaznovali. Težava je tudi, da se pri tem procesu kopiči ogromno podatkov, ki se kar ponujajo v zlorabo. Med argumenti, ki jih dajeta na primer policija ali Ministrstvo za notranje zadeve, najdemo predvsem težnje, da rabo teh tehnologij premaknejo čim bližje terenu. Policija si pri uporabi te in drugih tehnologij ne želi birokratskih ovir. Tisti, ki tehnologije ponujajo policistom in načelnikom, pa jih seveda za svojo korist prikazujejo kot bolj učinkovite od dejanskega stanja.

Policisti lastno delo dojemajo kot zelo zahtevno, saj lahko kriminalci brez omejitev »počnejo karkoli«, policisti pa »ne smejo delati ničesar«. To stisko seveda razumem, a menim, da lahko te tehnologije prinesejo ogromno potencialno nevarnih rab, zato moramo poskrbeti, da jih ne more uporabljati kar kdorkoli. S tem ne mislim le na scenarij, v katerem na oblast pride katastrofalno grozna vlada, ki si napiše zakone, pod katerimi ima popolnoma proste roke. Ne, skrbijo me predvsem ljudje, ki sprejemajo slabe življenjske odločitve in začnejo te stvari uporabljati na lastno pest, na čisto absurdne in trivialne načine.

Za lažjo predstavo navedite kakšen absurden ali trivialen primer.

Se bom tega raje lotil z zgovorno analogijo. V nekaterih nočnih klubih je fotografiranje prepovedano z razlogom. Ne gre za to, da bi si ljudje tam vbrizgavali heroin ali zganjali ne vem kakšne druge grozote. Ne, gre za to, da si ljudje želijo ustvariti skupnost, v kateri jih ne bo vsak trenutek strah. Da imamo v lastnih stanovanjih pravico do zasebnosti, je nekaj, kar nam omogoča psihično stabilnost in varnost. Ne smemo pozabiti, da velik del stvari, ki jih cenimo pri demokraciji, temelji ravno na pravici do zasebnosti. In to ne le zasebnosti v našem domu, temveč tudi v javnem življenju, na javnih površinah in v javnih prostorih. Pomembno je, da ko gremo na Trg revolucije, tisti trenutek za to ne ve čisto vsak. Morda smo tam zaradi nekih popolnoma trivialnih razlogov: morda gre le za to, da sem star sedemnajst let in želim protestirati, moja mama pa mi tega ne dovoli. Take neumnosti imajo lahko resne dolgoročne posledice, zato je pomembno, da se tovrsten nadzor omeji s čim več varovalkami.

© Luka Dakskobler

Zanimivo je, da ravno ljudje, kot je Sam Altman, direktor podjetja OpenAI, vztrajno opozarjajo na potrebo po globalni zakonodajni regulaciji umetne inteligence, sočasno pa, kot je prejšnji teden razkrila revija Time, ravno OpenAI pri EU v ozadju lobira za omilitev določenih elementov Akta o umetni inteligenci, ki bi lahko podjetje podvrgli pravnim zahtevam o transparentnosti. Kako komentirate tovrstno licemerstvo?

Ko Altman reče »potreba po regulaciji«, ima s tem v mislih »potrebo po definiciji zakonov«, saj želi gotovost. Seveda v ozadju lobirajo za specifično obliko tega zakona, ki bi bila v prid njim, v osnovi pa si predvsem želijo, da bi jim nekdo povedal, kaj vse si pravzaprav lahko dovolijo. Dobro vedo, da trenutno ni jasno, ali je to, kar počnejo, popolnoma zakonito, zato seveda želijo, da so pravila igre čim prej napisana. Hkrati pa lahko svoje želje in zahteve po regulaciji uporabijo tudi kot izgovor. Približno tako, kot če bi nekdo prišel v prostor s pištolo v roki in rekel: »Začnimo se pogovarjati o tem, kako bomo regulirali pištole. Jaz sem največji strokovnjak za pištole ta trenutek. Je kdo od vas kadarkoli v življenju naredil kakšno pištolo? Jaz sem jo. Pa nič slabega nočem, samo povejte mi, kako bomo ravnali s temi pištolami, da se kdo ne poškoduje.«

Pisma bralcev pošljite na naslov pisma@mladina.si. Minimalni pogoj za objavo je podpis z imenom in priimkom ter naslov. Slednji ne bo javno objavljen.